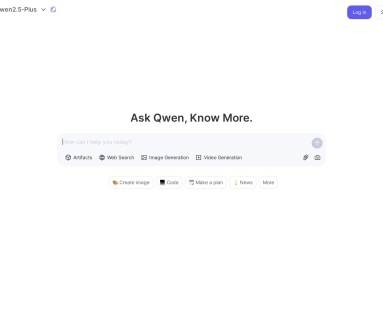

Qwen是什么

Qwen是由阿里巴巴旗下通义团队研发的一系列AI大语言模型和多模态模型,该系列模型的基础版本被称为Qwen(中文名:通义),经过后训练技术(如有监督微调SFT和强化学习人类反馈RLHF)训练的聊天模型则称为Qwen Chat(中文名:通义千问)。

阿里巴巴于2025年1月29日(农历大年初一)发布了Qwen旗舰版模型Qwen2.5-Max,Qwen2.5-Max在多个基准测试中超越了ChatGPT-4o、DeepSeek-V3及Llama-3.1-405B等顶尖AI大模型。

Qwen Chat是基于Qwen大模型开发的AI助手,整合了多个Qwen系列模型,可以为用户提供高效、智能的AI对话交互体验。Qwen Chat提供AI聊天对话、联网搜索、图像和视频生成、代码生成、文档处理等多种功能,支持文本、图像和视频等多模态交互,可以适用于多种场景下的应用需求。

Qwen Chat功能特点

✅ 多模型支持:

Qwen Chat整合了多个Qwen系列模型,包括通用对话模型(如Qwen2.5-Plus)、视觉语言模型(如Qwen2.5-VL-Max)、逻辑推理模型(如QwQ和QVQ)以及编程模型(如Qwen2.5-Coder-32B-Instruct)。

✅ 多模态交互:

Qwen Chat支持文本、图像和视频的输入与输出,用户可以通过上传文档、图片或视频进行操作,系统会根据内容生成相应的回答或输出结果。

✅ AI对话问答:

Qwen Chat支持进行多轮对话,可以理解上下文并生成连贯的回复,适用于日常对话、问题解答、内容创作等多种场景。

✅ 图像视频生成:

通过Qwen视觉语言模型,用户可以上传图片或视频,Qwen Chat能够解析图像内容并生成描述或相关回答。

✅ 代码生成优化:

Qwen Chat针对开发者提供了编程模型,可以自动生成代码片段、优化程序逻辑,并支持代码解释和调试功能。

✅ 文档处理编辑:

Qwen Chat支持上传PDF、Word、TXT等格式的文档,系统能够根据文档内容回答问题或提取关键信息,支持HTML格式的预览。

✅ 开源社区支持:

基于Qwen开源的Web UI框架,Qwen Chat支持开源和闭源模型,用户可以自由切换模型版本,并通过社区获取支持。

✅ 多种语言支持:

Qwen Chat支持多达29种语言,可以满足全球不同地区用户的使用需求。

Qwen如何使用

1、在线使用Qwen Chat网页版

Qwen提供网页版Qwen Chat,浏览器访问Qwen官网,注册登录后即可在线使用。

- Qwen官网_国际版:https://chat.qwen.ai/

- Qwen官网_中文版(通义千问):https://tongyi.aliyun.com/

- Qwen2.5-Max Demo版:https://huggingface.co/spaces/Qwen/Qwen2.5-Max-Demo

2、私有化部署Qwen开源版

Qwen遵循Apache 2.0许可证,鼓励开发者探索和创新,Qwen开源代码和文档可以在GitHub上找到。

- Qwen开源项目官网:https://qwenlm.github.io/

Qwen在阿里云百炼平台发布了Qwen系列API,支持企业和开发者在线调用Qwen最新模型。

- Qwen产品文档:https://www.alibabacloud.com/help/en/model-studio/developer-reference/what-is-qwen-llm

- Qwen 2.5部署指南:https://www.aliyun.com/solution/tech-solution/qwen2-5-for-platforms

Qwen大模型系列版本

Qwen大模型系列有多个版本,不同版本支持不同的参数规模和功能:

京公网安备11010502052249号

京公网安备11010502052249号

这么低级的错误吗?大年初一是几月几号都能写错!

小编疏忽,已改,感谢指正。